什么是大型语言模型 (LLM)?

大型语言模型定义

大型语言模型 (LLM) 本质上是使用深度学习算法训练的模型,能够执行各种自然语言处理 (NLP) 任务,例如情感分析、对话问答、文本翻译、分类和生成。LLM 是一类专门使用 Transformer 架构的神经网络 (NN)。该架构旨在检测数据序列中各部分之间的依赖关系,而不管它们彼此之间的距离。这些神经网络由多层处理单元组成,人们通常将其与大脑中的神经元相比较。大型语言模型也具有大量的参数,类似于模型从训练中学习时收集的各种记忆。我们可以将这些参数视为模型的知识库。

这种处理能力使大型语言模型能够被训练用于软件代码编写、语言生成等任务,而专用模型则负责处理理解蛋白质结构等任务。1大型语言模型必须经过预训练,然后再进行微调,以解决文本分类、问题解答、文档摘要、文本生成等问题及其他任务。它们解决问题的能力可以应用于医疗保健、金融和娱乐等多种领域。在这些领域中,大型语言模型可用于支持各种 NLP 应用程序,例如翻译、聊天机器人和 AI 助手。

观看此视频,深入了解大型语言模型。

大型语言模型是如何工作的?

从本质上而言,大型语言模型的工作原理是通过接收输入、对其进行编码,然后解码以生成输出预测,例如下一个字词、句子或特定答案。与所有机器学习模型一样,大型语言模型需要进行训练和微调,然后才能输出预期和所需结果。以下是其优化方式:

- 训练:大型语言模型会使用 Wikipedia 和 GitHub 等网站的大型文本数据集进行预训练。这些数据集包含数以万亿计的字词,它们的质量将影响语言模型的性能。在这个阶段,大型语言模型主要进行无监督学习,这意味着它会在没有特定指令的情况下处理输入的数据集。在这个过程中,算法学会识别字词与其上下文之间的统计关系。例如,它将学习理解“right”是“正确”的意思,还是“左”的反义词。

- 微调:为了使大型语言模型能够执行特定任务(例如翻译),必须针对该特定活动进行微调。微调通过使用额外的标注数据训练模型,调整其参数以优化其在特定任务上的性能。

- 提示调优的作用与微调类似,即通过少样本提示或零样本提示对模型进行训练,使其能够执行操作。少样本提示为模型提供示例来引导其预测输出,例如:

| 客户评论 | 客户情感 |

|---|---|

| “这株植物太漂亮了!” | 正面 |

| "这株植物太丑了!" | 负面 |

在这种情况下,模型理解了“hideous”的含义,因为提示为其提供了相反的例子(beautiful)。

然而,零样本提示不使用示例。相反,它直接要求模型执行任务,例如:

“‘这株植物太丑了’这句话中的情感是……”

基于先前的训练,模型必须在没有提供任何示例的情况下预测情感。大型语言模型的关键组件

大型语言模型由多个神经网络层组成。嵌入层、注意力层和前馈层协同工作,对输入文本进行处理并生成输出内容。

- 嵌入层会基于输入文本创建向量嵌入(即对输入字词的数学表示),模型的这一部分收集输入的语义和句法含义,以便模型可以在上下文中理解字词及其关系。

- 注意力机制使模型能够根据输入文本各部分与当前任务的相关性进行聚焦,从而捕捉长距离依赖关系。

- 前馈层由多个全连接层组成,对数据进行非线性变换。它们在注意力机制完成信息编码后,进一步处理这些数据。

大型语言模型主要有三种类型:

- 通用或原始语言模型根据训练数据中的语言预测下一个词。这些语言模型可执行信息检索任务。

- 指令调优的语言模型经过训练后,可预测输入中所给指令的响应。这可使用它们执行情感分析,或者生成文本或代码。

- 对话调优的语言模型经过训练后,可通过预测下一个响应来进行对话。例如,聊天机器人或对话 AI。

大型语言模型与生成式 AI 之间的区别?

生成式 AI 是一个总称,指的是能够生成内容的人工智能模型。这些模型可以生成文本、代码、图像、视频和音乐。它们还可以专门用于不同的内容类型,例如文本生成(如 ChatGPT)或图像创作(如 DALL-E、MidJourney)。

大型语言模型是一种生成式AI,专门在大规模文本数据集上进行训练,旨在生成文本内容,例如 ChatGPT。

所有大型语言模型都是生成式 AI,但并非所有生成式 AI 模型都是大型语言模型。例如,DALL-E 和 MidJourney 生成的是图像,而非文本。

什么是转换器模型?

转换器模型是大型语言模型中最常见的架构。它通常由编码器和解码器两部分组成,不过有些模型,例如 GPT,只使用解码器。转换器模型通过将输入信息转换为词元来处理数据,然后同时进行数学运算来发现词元之间的关系。这样,计算机就能够看到人类在面对同样查询时所看到的模式。

转换器模型使用自注意力机制工作,与长短期记忆模型等这类传统模型相比,这种模型的学习速度更快。自注意力使转换器模型能够比传统模型更好地识别字词之间的关系,即使是句子中相距较远的字词。实现这一点的主要方式是允许并行处理信息。

相关内容:在您的搜索应用程序中应用转换器

大型语言模型示例和用例

大型语言模型可用于多种用途:

- 信息检索:例如 Bing 或 Google。大型语言模型可以集成至搜索引擎中以优化查询响应。传统搜索引擎主要依赖索引算法运行,而大型语言模型则能基于查询内容生成更具对话性或语境感知能力的回答,提升系统性能。

- 情感分析:作为自然语言处理的应用,公司可利用大型语言模型来分析文本数据的情感。

- 文本生成:大型语言模型(如 ChatGPT)是生成式 AI 系统的核心,能够根据给定的提示生成连贯且符合语境的文本。例如,您可以提示大型语言模型:“用 Emily Dickinson 的风格给我写一首关于棕榈树的诗。”

- 代码生成:与文本生成一样,大型语言模型可以生成代码。这也是生成式 AI 的一种应用。大型语言模型可以通过学习大量各种语言的编程代码,根据输入提示生成语法正确和逻辑通顺的代码。

- 聊天机器人和对话式 AI:大型语言模型可为客户服务聊天机器人和对话式 AI 提供支持。它们协助解读客户查询,理解意图,并生成模拟人类对话的响应。

除了上述这些用例之外,大型语言模型还可以补全句子、回答问题和总结文本。

大型语言模型的应用范围如此广泛,在众多领域中都可以找到它的身影:

- 技术:大型语言模型用于多种应用,例如增强搜索引擎查询响应及协助开发人员编写代码。

- 医疗保健和科学:大型语言模型可以分析与蛋白质、分子、DNA 和 RNA 有关的文本数据,协助研究、疫苗开发、确定疾病的潜在治疗方法以及改进预防保健药物。大型语言模型还被用作医疗聊天机器人,用于患者收治或基本诊断,尽管它们通常需要人工监督。

- 客户服务:大型语言模型广泛应用于各行各业的客户服务领域,例如聊天机器人或对话式 AI。

- 市场营销:市场营销团队可利用大型语言模型进行情感分析、内容生成和策划活动创意,帮助生成用于宣传、广告及其他材料的文案。

- 法律:从搜索海量法律数据集到起草法律文件,大型语言模型可以为律师、律师助理和法律工作者提供帮助。

- 银行业:大型语言模型可以协助分析金融交易和客户沟通,以检测潜在的欺诈行为,通常集成于综合欺诈检测系统中。

在企业中开始使用生成式 AI。观看此网络研讨会,探索生成式 AI 在企业环境中的挑战和机遇。

大型语言模型的局限性和挑战

大型语言模型可能会给我们留下这样的印象:它们理解含义,并且能够准确地做出响应。然而,它们仍然是一种需要人类监督的工具,并面临各种挑战。

- 幻觉:幻觉是指大型语言模型生成错误的输出,或与用户意图不符的输出。例如,声称自己是人类,有情感,或是爱上了用户。由于大型语言模型会预测下一个语法正确的字词或短语,但无法完全解读人类的意思,因此导致有时会产生所谓的“幻觉”。

- 安全性:如果管理或监测不当,大型语言模型会带来严重的安全风险。它们可能会无意中泄露训练数据中或与用户互动时获得的私人信息,并被用于网络钓鱼或生成垃圾邮件等恶意目的。怀有恶意的用户也可能利用大型语言模型来传播有失偏颇的意识形态、虚假信息或有害内容。

- 偏差:用于训练语言模型的数据会影响给定模型生成的输出。如果训练数据缺乏多样性或偏向特定人群,模型可能会重现这些偏见,进而生成反映片面(并且可能狭隘)的输出结果。确保训练数据集多样化且有代表性是减少模型输出偏见的关键。

- 同意:大型语言模型是使用海量数据集训练的结果,其中部分数据可能是在未获得明确同意或未遵守版权协议的情况下收集的。如果未注明内容出处或在未经许可的情况下复制内容,就有可能导致侵犯知识产权的行为。此外,这些模型可能会收集个人数据,从而引发隐私问题。2大型语言模型曾面临法律挑战,例如 Getty Images3 等公司以侵犯版权为由提起诉讼。

- 扩展:扩展大型语言模型可能会占用大量资源,需要大量的算力支持。维护此类模型涉及持续的更新、优化和监测,是一个既耗时又费钱的过程。用于支撑这些模型的基础设施也很庞大。

- 部署:部署大型语言模型需要深厚的深度学习和 Transformer 架构专业知识,以及专用硬件和分布式软件系统。

大型语言模型的优势

大型语言模型的应用范围非常广泛,由于能够以清晰、对话式的方式提供信息,易于用户理解,因此对解决问题非常有益。

- 应用领域广泛:大型语言模型可用于语言翻译、句子补全、情感分析、问题解答、数学公式等。

- 持续改进:随着额外数据和参数的增加,大型语言模型的性能也会随之提高。这种改进还受模型架构和所添加的训练数据的质量等因素影响。换句话说,学得越多,性能越好。此外,大型语言模型还可以展现出所谓的“语境学习”。通过这种学习,模型可以根据提示中提供的示例执行任务,而无需额外的训练或参数。这使得模型仅需少量样本(少样本学习),甚至无需先验样本(零样本学习)即可泛化并适应各种任务。这样,它就可以持续学习。

- 高效学习:借助语境学习,大型语言模型能够在样本极少的情况下适应新任务。虽然无需额外的训练或参数,但它们能够快速响应提示的语境,因此在提供少量样本的情况下会有高效表现。

常用大型语言模型示例

很多常用的大型语言模型已经风靡全球。其中有许多已经被各行各业的人们所采用。您一定听说过 ChatGPT 这种生成式 AI 聊天机器人。

其他常用的大型语言模型还包括:

- PaLM:Google 的 Pathways Language Model (PaLM) 是一种转换器语言模型,能够进行常识和算术推理、笑话解释、代码生成和翻译。

- BERT:基于转换器的双向编码器表示 (BERT) 语言模型也是在 Google 开发的。它是一个基于转换器的模型,可以理解自然语言并回答问题。

- XLNet:排列语言模型 XLNet 在训练阶段采用所有可能的输入词元排列组合进行学习,但在推理过程中仍以标准的从左到右方式生成预测结果。

- GPT:生成式预训练转换器可能是最著名的大型语言模型。由 OpenAI 开发的 GPT 是一种热门基础模型,其带编号的迭代都是对前代(GPT-3、GPT-4 等)的改进。GPT 模型可针对特定任务进行微调。此外,其他组织也基于基础大型语言模型开发了相关领域的专用模型,例如 Salesforce 为客户关系管理应用开发的 EinsteinGPT,以及 Bloomberg 为金融数据处理开发的 BloombergGPT。

大型语言模型中的未来发展

ChatGPT 的出现将大型语言模型推到了风口浪尖,并引发了人们对未来的猜测和激烈辩论。

随着大型语言模型的不断发展,这些模型对自然语言的掌握程度也在不断提高,人们对它们的进步会对就业市场产生什么影响非常关注。

在合适的手中,大型语言模型可以提高生产力和流程效率,但这对它们在人类社会中的使用提出了伦理问题。

了解 Elasticsearch Relevance Engine

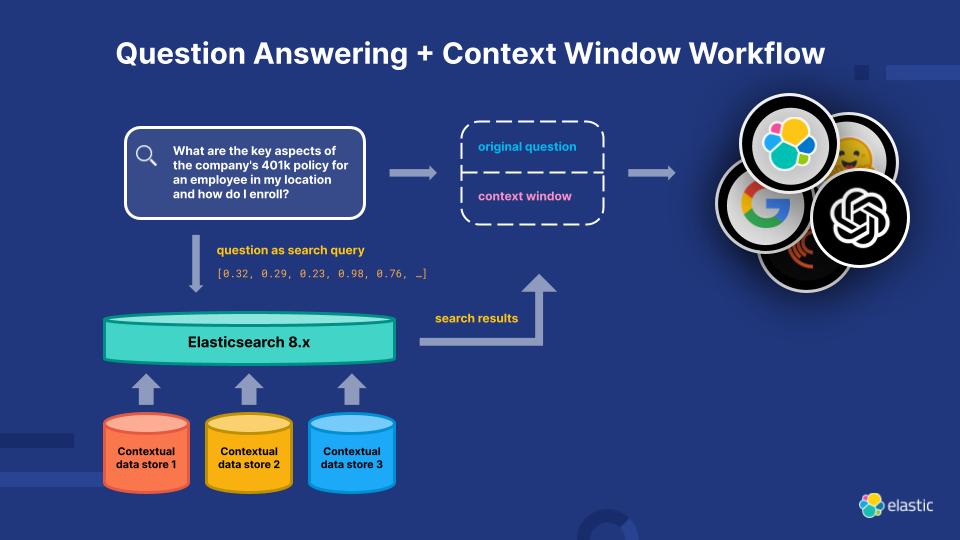

为了解决当前 LLM 的局限性,Elasticsearch Relevance Engine (ESRE) 是一款专为人工智能驱动的搜索应用程序而构建的关联引擎。借助 ESRE,开发人员可以构建自己的语义搜索应用程序,利用自己的转换器模型,并结合 NLP 和生成式 AI 来增强客户的搜索体验。

使用 Elasticsearch Relevance Engine 提升相关性

探索更多大型语言模型资源

- LLM 可观测性

- Elastic 生成式 AI 工具和功能

- 如何选择向量数据库

- 如何打造聊天机器人:开发者的注意事项和禁忌

- 选择 LLM:开源 LLM 入门指南

- Elasticsearch 中的语言模型

- 2025 技术趋势:拥抱“选择时代”,推动 GenAI 实现产业化落地

- Elastic Stack 中的自然语言处理 (NLP) 概述

- 使用 Elastic Stack 的可兼容第三方模型

- Elastic Stack 中已训练模型的指南

- LLM 安全评估

脚注

- 作者:Sarumi, Oluwafemi A. 和 Dominik Heider;标题:“Large Language Models and Their Applications in Bioinformatics”(大型语言模型及其在生物信息学中的应用);《计算与结构生物技术》杂志,第 23 卷,2024 年 4 月,第 3498–3505 页。

https://www.csbj.org/article/S2001-0370(24)00320-9/fulltext。 - 作者:Sheng、Ellen;标题:“In generative AI legal Wild West, the courtroom battles are just getting started”(在生成式 AI 的法律荒原中,法庭之争才刚刚开始);发布日期:2023 年 4 月 3 日 (CNBC);网址:https://www.cnbc.com/2023/04/03/in-generative-ai-legal-wild-west-lawsuits-are-just-getting-started.html(2023 年 6 月 29 日访问)。

- Getty Images 声明,Getty Images,2023 年 1 月 17 日 https://newsroom.gettyimages.com/en/getty-images/getty-images-statement(访问日期:2023 年 6 月 29 日)。